El algoritmo vio un arma

Cuando la vigilancia de IA convierte un bocadillo en una amenaza

- Un estudiante de 16 años en Baltimore fue detenido a punta de pistola por la policía después de que un sistema de vigilancia de IA identificara erróneamente su bolsa de Doritos como un arma de fuego.

- La tecnología defectuosa, un sistema de detección de armas Omnilert utilizado por la escuela, analiza las transmisiones de las cámaras de seguridad y envía automáticamente alertas a las fuerzas del orden.

- El incidente destaca el grave costo humano de tales errores, que causan trauma para el estudiante y los testigos, y es parte de un patrón más amplio de extralimitación automatizada en la seguridad escolar.

- Un problema central es la "infalibilidad percibida" de la IA, donde la alerta de un algoritmo puede anular el juicio crítico humano, lo que lleva a una respuesta armada peligrosa e incuestionable.

- El caso es una llamada de atención nacional, que subraya la necesidad urgente de auditorías independientes, protocolos sólidos de verificación humana y una mayor responsabilidad antes de implementar dicha tecnología en espacios públicos.

En una cruda demostración de los peligros de la policía automatizada, un adolescente de Baltimore fue detenido a punta de pistola por oficiales después de que un sistema de vigilancia de inteligencia artificial identificara erróneamente su bolsa de Doritos como un arma de fuego.

El episodio se desarrolló la noche del 20 de octubre afuera de Kenwood High School. Taki Allen, de dieciséis años, que acababa de terminar la práctica de fútbol, estaba sentado con amigos cuando la rutina de un refrigerio después de la escuela se convirtió en una confrontación traumática.

Varias patrullas de la policía descendieron a la escena y los oficiales se acercaron a Allen con sus armas desenfundadas. Lo obligaron a arrodillarse, lo esposaron y lo registraron antes de que los oficiales revelaran el catalizador de la dramática respuesta: una imagen granulada, generada por una alerta de IA, que pretendía mostrar un arma.

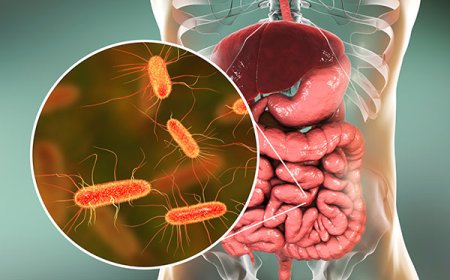

La tecnología en el corazón del incidente es un sistema de detección de armas desarrollado por la empresa Omnilert. Adoptado por las Escuelas Públicas del Condado de Baltimore el año pasado, el sistema utiliza una forma de inteligencia artificial conocida como visión por computadora. En términos simples, analiza continuamente las transmisiones de video en vivo de las cámaras de seguridad de las escuelas, programadas para reconocer los patrones visuales y las formas de las armas de fuego. Cuando identifica una posible coincidencia, envía automáticamente una alerta a los administradores escolares y a la policía local.

Sin embargo, el incidente ha encendido un feroz debate sobre el rápido despliegue de la seguridad impulsada por la IA en las escuelas públicas. Plantea preguntas críticas sobre la seguridad pública, los prejuicios raciales y la peligrosa falibilidad de la tecnología a la que se le confían cada vez más decisiones de vida o muerte.

A raíz del evento, Omnilert reconoció el error, pero ofreció una defensa que ha preocupado a los defensores de las libertades civiles. La compañía declaró que el sistema, de hecho, había "funcionado según lo previsto" al marcar un objeto que percibía como una amenaza. Omnilert enfatizó que su producto "prioriza la seguridad y la conciencia a través de la verificación humana rápida", un paso que parece haber sido eludido o acelerado en este caso, lo que lleva directamente a una respuesta policial armada contra un niño desarmado.

Para Allen, el fracaso abstracto de un algoritmo se tradujo en un momento de puro terror. Describió el temor de que lo mataran por un malentendido.

El impacto psicológico de ser tratado como una amenaza letal por las autoridades armadas es profundo, una experiencia que ningún estudiante debería enfrentar mientras come papas fritas en los terrenos de la escuela. El distrito escolar, reconociendo este trauma, prometió en una carta a las familias que se pondría a disposición de Allen y los otros estudiantes que presenciaron el evento.

Vigilancia de IA: ¿Una nueva era de seguridad escolar o extralimitación?

Este incidente no es una falla aislada, sino parte de un patrón inquietante que surge a medida que la IA se integra en la seguridad escolar. Se hace eco del caso de un estudiante de secundaria de Tennessee que fue detenido porque un filtro de contenido automatizado no entendió una broma, marcando un texto inocente como una amenaza. En ambos escenarios, la tecnología comercializada como una red de seguridad proactiva funcionó como un acusador automatizado, creando crisis donde no existía.

Un problema central radica en la infalibilidad percibida de los sistemas automatizados. Cuando una IA genera una alerta, puede tener una autoridad inmerecida, lo que provoca una respuesta elevada, a menudo incuestionable, de los operadores humanos.

Esto crea un ciclo de retroalimentación peligroso en el que la urgencia de una detección "positiva" de una computadora anula el juicio crítico y la conciencia contextual que solo un oficial humano puede proporcionar. El algoritmo no puede discernir la intención o comprender la realidad mundana de la merienda de un adolescente.

"Un algoritmo de IA es un procedimiento matemático que permite a las máquinas replicar la toma de decisiones similar a la humana para tareas específicas", dijo Enoch de BrightU.AI. "Procesa la información dividiéndola en tokens y relacionándolos probabilísticamente utilizando principios como el álgebra lineal. Esto permite que la IA analice datos y genere respuestas basadas en los patrones que ha aprendido".

El caso de Baltimore encaja perfectamente en el marco en expansión de la vigilancia masiva en la vida estadounidense. Desde el reconocimiento facial en los aeropuertos hasta los algoritmos de vigilancia predictiva, las herramientas de monitoreo se están volviendo omnipresentes.

En las escuelas, esto representa un cambio fundamental en el entorno. Estos sistemas de vigilancia están transformando las instituciones educativas de lugares de aprendizaje en espacios patrullados digitalmente donde cada movimiento de los estudiantes está sujeto a análisis automatizados y posibles interpretaciones erróneas.

El incidente obliga a una pregunta difícil: ¿Quién es responsable cuando una IA se equivoca? ¿Es la empresa que desarrolló y vendió el software defectuoso? ¿El distrito escolar que lo compró sin suficientes salvaguardas? ¿O los oficiales de policía que actuaron por recomendación con fuerza letal? Los marcos legales y éticos actuales están mal equipados para manejar la responsabilidad difusa inherente a las decisiones impulsadas por la IA.

Avanzar requiere un enfoque más escéptico y regulado de la vigilancia de la IA. Es esencial realizar una auditoría independiente de estos sistemas para verificar la precisión y el sesgo. Además, se deben establecer protocolos que exijan una verificación humana sólida antes, no después, de que se inicie una respuesta armada. La transparencia sobre las capacidades y las tasas de falla de esta tecnología es un requisito previo no negociable para su uso en espacios públicos.

La imagen de un adolescente arrodillado en el suelo a punta de pistola sobre una bolsa de papas fritas es un poderoso símbolo de un sistema que falla. Es un fracaso de la tecnología, de la política y del discernimiento humano básico que nunca debería subcontratarse a una máquina.

Fuente: Natural News

¿Cuál es tu reacción?