¿Veremos pronto jueces robots en los tribunales?

¿Será la inteligencia artificial un desastre?

Las visiones del futuro de la ciencia ficción incluyen muchas versiones de Inteligencia Artificial (IA), pero hay pocos ejemplos en los que el software reemplace a los jueces humanos. Pero en febrero de 2023, un juez colombiano le pidió a ChatGPT orientación sobre cómo decidir un caso de seguro. Casi al mismo tiempo, un juez paquistaní utilizó ChatGPT para confirmar sus decisiones en dos casos separados. También hay informes de jueces en India y Bolivia que buscan asesoramiento de ChatGPT.

Estos son experimentos no oficiales, pero en China, por ejemplo, los jueces son asesorados y asistidos por IA, y es probable que este desarrollo continúe. Recientemente, Sir Geoffrey Vos, el segundo juez más alto de Inglaterra y Gales, sugirió que a medida que se digitalice el sistema legal en esa jurisdicción, la IA podría usarse para decidir algunas disputas menos importantes, como los casos comerciales.

El uso de IA en los tribunales inicialmente parecería una buena idea. La ley debe aplicarse imparcial y objetivamente, sin temor ni favoritismo. Y, ¿qué mejor manera de lograrlo que usar un programa de computadora? La IA no necesita una pausa para almorzar, no puede ser sobornada y no quiere un aumento salarial. La justicia de IA se puede aplicar de manera más rápida y eficiente. Entonces, ¿veremos "jueces robot" en los tribunales en el futuro?

Pero hay algunas razones por las que esto podría no ser una buena idea. En primer lugar, la IA generalmente actúa como un sistema experto o un sistema de aprendizaje automático. Los sistemas expertos implican codificar reglas en un modelo de decisión y sus consecuencias, llamadas árbol de decisión, en software. Tuvieron su apogeo en la ley en la década de 1980. Sin embargo, finalmente demostraron ser incapaces de ofrecer buenos resultados a gran escala.

El aprendizaje automático es una forma de IA donde la mejora lleva tiempo. La IA puede encontrar correlaciones y patrones en datos que no tenemos la capacidad de calcular. Sin embargo, una de sus debilidades es que falla de manera diferente a como lo hacen los humanos, llegando a conclusiones que obviamente son incorrectas.

En un ejemplo notable, la IA fue engañada para reconocer a una tortuga como arma. El reconocimiento facial a menudo tiene problemas para identificar correctamente a las mujeres, los niños y las personas de color. Por lo tanto, es posible que la IA haya colocado por error a alguien en una escena del crimen que no estaba allí. Sería difícil confiar en un sistema legal que ha producido resultados claramente incorrectos, pero también muy difícil de revisar, porque el razonamiento detrás del aprendizaje automático no es transparente.

Cuando la IA se utiliza en procesos legales y falla, las consecuencias pueden ser graves. En 2023, un abogado de Nueva York usó ChatGPT para escribir presentaciones a un tribunal, solo para descubrir que citaba casos que no existen.

Entonces, no olvide que los sistemas de aprendizaje automático se basan en datos históricos. En el crimen y la ley, a menudo contendrán sesgos y prejuicios. Las comunidades marginadas a menudo aparecerán más en los registros de arrestos y condenas, por lo que un sistema de IA podría sacar la conclusión injustificada de que las personas de ciertos orígenes tienen más probabilidades de ser culpables.

En tercer lugar, no está claro que las normas jurídicas puedan convertirse de manera fiable en reglas de software. Los individuos interpretarán la misma regla de diferentes maneras. Los jueces individuales pueden tener diferentes interpretaciones de la ley.

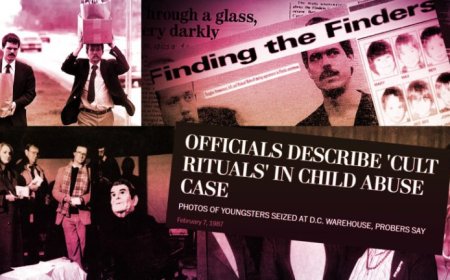

Los sistemas gubernamentales automatizados fallan a una escala y velocidad asombrosas. El gobierno holandés utilizó un sistema automatizado (SyRI) para detectar el fraude de beneficios, acusando erróneamente a muchas familias, destruyendo vidas en el proceso.

Al final, juzgar no es todo lo que hacen los jueces. Tienen muchas otras funciones en el sistema legal, como la gestión de una sala de audiencias, el número de casos y el equipo de personal, y estos serían aún más difíciles de reemplazar con software.

Fuente: Lovendal

¿Cuál es tu reacción?