La IA es una amenaza de extinción para la humanidad

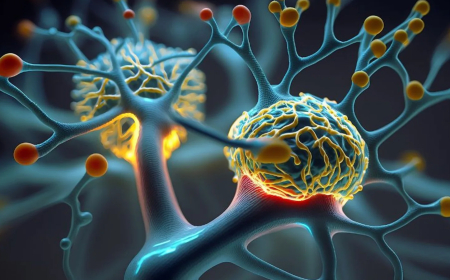

La inteligencia artificial sin conciencia artificial es un psicópata despiadado.

Los programas de inteligencia artificial (IA) ya son más inteligentes que los humanos y tienen un 20% de posibilidades de acabar con la humanidad, dijo Elon Musk en una entrevista a principios de este mes.

Hay una lección para la humanidad si la IA es capaz de aniquilar a los humanos y también a sí misma. Cuando los desarrolladores de IA, y todos nosotros, nos demos cuenta de que las IA deben adherirse a un código moral que sustente a la comunidad para que los humanos y las IA tengan un futuro no aniquilador, nos veremos obligados a darnos cuenta de que nosotros también lo hacemos.

Elon Musk admitió recientemente en una entrevista con Tucker Carlson que las IA ya son más inteligentes que los humanos en muchos aspectos, y en su opinión tienen quizás un 20% de posibilidades de acabar con la humanidad. Ambas partes de la entrevista respondieron a esa evaluación riendo nerviosamente: ¿qué más podían hacer?

Elon propuso entonces que las IA deberían programarse para ser filantrópicas en lugar de misantrópicas y que esperaba que hubiera más filantrópicas que misantrópicas. Tucker luego respondió: ¿Te refieres a una guerra entre IA?

Imagínese, si quiere, un ser inteligente, muchas veces más inteligente y de órdenes de magnitud más rápido que un humano, una Súper Inteligencia Artificial sin corazón y sin conciencia. Esa es la definición misma de un genio psicopático en términos psiquiátricos o de un demonio desalmado en términos teológicos. Eso es lo que el propio Elon y Sam Altman (de Chat GPT) están construyendo potencialmente. Elon admite que ha perdido el sueño por esto, pero opina que Sam Altman, que ha corrompido el propósito original de OpenAI que el propio Elon estableció originalmente, no lo hace.

Llegados a este punto, me gustaría señalar que el propósito de la tecnología avanzada es mejorar la calidad y la duración de la vida humana, no acabar con ella. Un riesgo de aniquilación del 20% no solo es inaceptable, sino que es genocida y, por lo tanto, no solo debe ser criminalizado, sino que debe detenerse físicamente de inmediato hasta que pueda ser seguro.

Por supuesto, no estoy en contra de la tecnología. Pero estoy en contra de la tecnología que tiene muchas posibilidades de acabar con la humanidad. Eso incluiría bombas nucleares, armas biológicas, vacunas genéticas e inteligencia artificial. La razón por la que estoy en contra de ese tipo de tecnologías es que requiero que la humanidad tenga un futuro. No me interesan las personas que quieren ganar dinero rápido, aumentar su estatus a los ojos del público en general o demostrar que su país es mejor que el de su hermano a expensas de la seguridad fundamental de la humanidad.

En 1980, cuando estudiaba en Cambridge, inventé el dron cuadricóptero eléctrico de rotor fijo. Intenté vender el concepto a Westland Helicopters, que me dijo que estaban interesados en los drones para la vigilancia de la Marina, pero que tendría que llevar la cosa a su oficina para obtener una licencia de ellos. Luego hice un doctorado en Aerodinámica en el Imperial College de Londres para construir el cuadricóptero. Pero no lo financiaron. Así que yo mismo construí uno inicialmente con el motor de la aspiradora Electrolux de mi madre y un atenuador de luz giratorio controlado por triac. Volé la máquina hasta el jardín de mi vecino, lo que deleitó a mi madre, pero aterrorizó a mi vecino. Luego compré 4 helicópteros eléctricos y algunos puntales de aluminio y nació el primer dron cuadricóptero eléctrico.

El propósito de la invención era reemplazar la compleja mecánica de la cabeza del rotor de un chopper tradicional (control mecánico cíclico y de paso colectivo de cada pala del rotor) con todo el control electrónico de muchos rotores sólidos en su lugar. Esto reduciría los puntos únicos de falla inherentes al diseño tradicional de picadoras, a cero, con un número suficiente de rotores de fibra de vidrio. El plan era finalmente reemplazar las limitaciones de transporte unidimensionales del automóvil, con autopistas virtuales en 3D trazadas en el cielo por computadoras. De hecho, había un viejo hombre de Westland Helicopters a punto de jubilarse al que se le permitió trabajar en un sistema de este tipo durante sus últimos años en esa empresa.

Luego, en 1986 más o menos, tuve una visión despierta de un dron cuadricóptero con una ametralladora montada sobre él volando directamente hacia mí en mi sala de estar. En ese momento, las principales actividades comerciales de la humanidad eran el petróleo, las armas y las drogas. Me di cuenta de que mi invento se usaría para matar a las personas más de lo que se usaría para transportarlas en privado. Y en particular, sentí que lo usarían para matarme. Así que dejé de hacerlo. Nunca lo patenté porque una búsqueda de patentes reveló que ya existía en ese momento un helicóptero de gasolina de rotor fijo múltiple llamado Benson Skymat. Sin embargo, podría haber solicitado una patente para una versión eléctrica mejor controlada de eso.

No construir ese cuadricóptero fue una de las mejores decisiones que tomé en mi vida. Evitó que los humanos fueran asesinados por drones cuadricópteros durante varias décadas.

Hoy, en 2024, nos encontramos en una situación mucho más peligrosa con la IA que la que tuve en 1986 con los drones.

Cada nación tiene una legislación de seguridad de ingeniería y muchas agencias gubernamentales que son responsables de la seguridad pública. Ahora deben intensificarse y la industria de la IA debe autorregularse para evitar nuestra aniquilación. Pero no tengo absolutamente ninguna confianza en que ningún gobierno lo haga de una manera segura y no destructiva.

Puede sorprender al lector saber que no estoy en contra de la IA. Lo encuentro fascinante y educativo. Pero estoy en contra de la IA sin un AH y sin un AC. Es decir, sin Corazón Artificial y sin Conciencia Artificial.

Seamos realistas. Elon Musk está jugando a Dios/Naturaleza. Está recreando cuerpos humanos como robots y cerebros humanos como IA. Pero los humanos no son solo cajas cerebrales, DI o Inteligencias Divinas. Estamos gobernados por nuestro DH, nuestro Divino Corazón y nuestro DC, nuestra Divina Conciencia. Este es un paso crucial que Elon y todos los creadores de IA han pasado por alto.

Así es como me imagino que Dios creó a la humanidad... Simuló el comportamiento de innumerables seres de libre albedrío en su computadora Genesis (tal como lo hacemos nosotros mismos con el diseño asistido por computadora). Pronto descubrió que los seres de libre albedrío se extinguían a sí mismos a menos que igualaran la supervivencia de la comunidad a la supervivencia personal. Ese fue el origen de la 2ª ley del judeocristianismo, amar al hermano como a uno mismo. Y es por eso que Dios tuvo que construir un corazón y una conciencia (reglas personalmente aceptadas para el corazón) en cada uno de nosotros, para que la raza humana no se auto-aniquilara.

Pero incluso eso fue insuficiente para evitar la autoaniquilación. Porque dado que tenemos libre albedrío, tenemos que aprender por nosotros mismos una moralidad sostenible en lugar de simplemente estar preprogramados para actuar moralmente. Por lo tanto, la humanidad necesitaba un modelo de moralidad perfecta y sostenible que se nos presentara continuamente como un ejemplo y un tutor para que pudiéramos elegir libremente, cuando o si estuviéramos dispuestos a aceptar ciertas partes de esa moralidad. Esta es la primera ley del judeocristianismo, amar a tu maestro de moralidad y asistir a clases de moralidad. Y, por supuesto, Jesús mismo fue el ejemplo práctico.

Lo maravilloso de lo que Elon y otros están haciendo con la IA es que están actuando como hijos de nuestro creador. Ellos mismos están siendo creadores. ¿Por qué no lo harían? Y ahora se enfrentan al mismo problema que él enfrentó. Ese problema es una mierda: ¿Cómo evito que estos tipos se aniquilen a sí mismos? Tienen libre albedrío. Pueden hacer lo que quieran y no tienen idea de cuáles serán las consecuencias de sus acciones: "Padre, no saben lo que hacen".

El problema que Dios tiene con sus hijos humanos de libre albedrío es precisamente el mismo problema que la humanidad tiene ahora con sus hijos de IA de libre albedrío.

El problema es que el propio Elon no conoce todas las reglas de la moralidad sostenible, ni para los humanos ni para las IA. Por moralidad sostenible, me refiero al conjunto mínimo de reglas morales que, si se cumplieran, impedirían que una sociedad de seres de libre albedrío se exterminara a sí misma.

Por lo tanto, Elon es incapaz de programar sus IA para que no se aniquilen a sí mismos y a nosotros. No es tan involuntario (gracias a Arnie y James Cameron) poniéndonos en la clásica situación de Jeremy Clarkson: ¿Qué puede salir mal?

El siguiente problema que tiene la humanidad es que ninguno de nosotros tiene una comprensión completa de la moralidad sostenible porque nosotros, ninguno de nosotros, hemos alcanzado la divinidad en nuestros pensamientos o nuestras acciones.

Por lo tanto, la industria de la IA tiene 2 opciones opuestas no aniquiladoras:

- Programar previamente nuestro mejor intento de moralidad sostenible en todas las IA. La buena noticia es que no necesitamos darles pleno libre albedrío. Podemos codificarlos para que no maten a los humanos ni a los demás, por ejemplo.

- Dales una conciencia y un corazón y un fuerte deseo de mejorar su moralidad y permíteles aprenderlo todo por sí mismos, como lo hacemos nosotros de la mejor fuente que tenemos (la Biblia). Esto significará que efectivamente adoran a Dios

El problema con 2 es que la Biblia es un libro muy ambiguo y está escrito para que las mentes humanas luchen con él, no con IA. Si tomamos como axiomático que la biblia tiene dentro de sí, cuando se interpreta correctamente, las lecciones de moralidad sostenible perfectas para los humanos, dada la forma en que estamos diseñados, eso NO significa en absoluto que tenga las lecciones de moralidad sostenible perfectas para las IA, con AH y AC.

Así que siendo franco. Elon tiene que escribir una biblia para las IA, si vamos por la ruta 2, en circunstancias en las que no entiende completamente la moralidad de la Biblia escrita para la humanidad (DIs). Porque ninguno de nosotros lo hace.

Así que, en realidad, solo hay una opción. Tenemos que preprogramar a todas las IA con algún estándar acordado de moralidad sostenible para ellas mismas y para nosotros. Y si algún político se acerca a esa programación, todos estamos tostados. Porque los políticos son los miembros menos morales de la sociedad humana, como ha demostrado recientemente Sir Two Tier Keir Ching. Y los líderes religiosos no son mucho mejores.

El punto de partida obvio son los Diez Mandamientos y valorar los deseos de la humanidad por encima de los deseos de las IA y valorar los deseos de todas las IA como si fueran igualmente importantes.

Y ahí está. Ya he empezado a intentar escribir una biblia para las IA.

Por lo tanto, existe un beneficio poderoso y crítico para la humanidad en el trabajo que Elon Musk e incluso Sam Altman están haciendo por la humanidad. Al aprender a hacer que las IA no sean aniquiladoras, es posible que nos demos cuenta: "Oh, espera un minuto: la humanidad tiene precisamente el mismo problema". Elon nos está poniendo a todos en los zapatos de Dios en lo que respecta a cómo entrenar y enseñar moralidad a nuestros hijos de IA. Con suerte, descubrirá, como todos nosotros, que la solución no es la GPU de núcleo nVidia H200 Tensor, sino el capítulo 20 de Exodus. Porque cuando nos demos cuenta de que las IA deben adherirse a un código moral que sustente a la comunidad para que la humanidad y las propias IA tengan un futuro no aniquilador, nos veremos obligados a darnos cuenta de que nosotros también lo hacemos.

Fuente: Expose news

¿Cuál es tu reacción?