AI en el trabajo

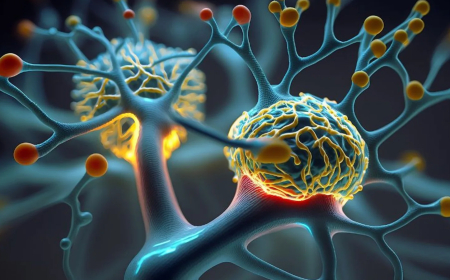

Hemos escuchado las advertencias de Yuval Noah Harari, de que si no descabemos cómo regular los cerebros humanos de la inteligencia artificial (IA) será hackeado pronto, una declaración que podría decirse que habla de los peores temores de la humanidad sobre la IA. Esto puede ser especialmente así, cuando se escucha de la asesora de Schwabs Harari que hacerle un golpe a un ser humano es conocer a esa persona mejor de lo que se conocen a sí mismos, lo que puede permitir a aquellos que poseen la tecnología nos manipule cada vez más.

Podemos creer que esta amenaza extrema a nuestra privacidad ocurrirá en algún momento en el futuro, pero, el hacking Harari está describiendo es más proverbial que literal, y ya ha estado ocurriendo en entornos como Facebook y YouTube donde se nos lleva a ver contenido que los algoritmos han considerado de interés para nosotros. Ahora parecería que muchos se han desensibilitado gradualmente a ella el "hacking- y la manipulación que le permite aumentar sin demasiada protesta".

Pero cómo te sentirías si tu lugar de trabajo estuviera rastreando cómo te sientes? Pregíntes a Nazanin Andalibi, quien es profesora asistente de Información en la Universidad de Michigan. y en el artículo a continuación diseñe la emoción AI que ya se está utilizando en el lugar de trabajo.

Emotion-Tracking - AI en el trabajo: Trabajadores Temen ser vigilado y entendido.

Por Nazanin Andalibi

La inteligencia artificial emocional utiliza señales biológicas como tono vocal, expresiones faciales y datos de dispositivos portátiles, así como texto y cómo la gente usa sus computadoras, prometiendo detectar y predecir cómo se siente alguien. Se utiliza en contextos tanto mundanos, como entretenimiento, como las altas apuestas, como el lugar de trabajo, la contratación y la atención médica.

Una amplia gama de industrias ya utilizan la emoción IA, incluyendo centros de llamadas, finanzas, banca, enfermería y cuidado. Más del 50% de los grandes empleadores en los EE.UU. usan la emoción IA con el objetivo de inferición de los empleados.grew during the COVID-19 pandemic Por ejemplo, los centros de llamadas monitorean lo que dicen sus operadores y su tono de voz.

Los estudiosos han planteado preocupaciones sobre la validez científica de la emoción IA y su dependencia de las teorías disputadas sobre la emoción. También han destacado el potencial de la emoción para invader la privacidad y exhibir prejuicios raciales, de género y de discapacidad.

Algunos empleadores utilizan la tecnología como si fuera impecable, mientras que algunos estudiosos buscan reducir su sesgo y mejorar su validez, desacreditarla por completo o sugerir prohibir la emoción AI, al menos hasta que se conozca más sobre sus implicaciones.

Estudio las implicaciones sociales de la tecnología. Creo que es crucial examinar las implicaciones de la emoción para las personas sometidas a ella, como los trabajadores, especialmente aquellos marginados por su raza, género o estado de discapacidad. No exactamente.

Trabajadores, preocupaciones

Para entender hacia dónde va la emoción que la IA en el lugar de trabajo va, mi colega Karen Boyd y yo nos propusimos examinar inventores. Concepciones de la IA de emoción en el lugar de trabajo. Analizamos las solicitudes de patentes que proponían tecnologías de IA de emoción para el lugar de trabajo. Las prestaciones perdidas reclamadas por los solicitantes de patentes incluían evaluar y apoyar el bienestar de los empleados, garantizar la seguridad en el lugar de trabajo, aumentar la productividad y ayudar en la toma de decisiones, como la realización de ascensos, el despido de empleados y la asignación de tareas.

Nos preguntamos qué piensan los trabajadores de estas tecnologías. También percibirían estos beneficios? Por ejemplo, a los trabajadores les resultaría beneficioso que los empleadores les proporcionaran apoyo al bienestar?

Mis colaboradores Shanley Corvite, Kat Roemmich, Tillie Ilana Rosenberg y yo realizamos una encuesta parcialmente representativa de la población estadounidense y en parte sobremuestrada para personas de color, personas trans y no binarias y personas que viven con enfermedades mentales. Estos grupos pueden ser más propensos a experimentar daño de la IA de emoción. Nuestro estudio contó con 289 participantes de la muestra representativa y 106 participantes de la muestra. Encontramos que el 32% de los encuestados reportó haber experimentado o que no les esperaban beneficio del uso de la IA de emociones, ya sea actual o anticipada, en su lugar de trabajo.

Aunque algunos trabajadores notaron posibles beneficios del uso de la inteligencia artificial por emoción en el lugar de trabajo, como el aumento del apoyo al bienestar y la seguridad en el lugar de trabajo, reflejando los beneficios reclamados en las solicitudes de patentes, todos también expresaron preocupaciones. Les preocupaba el daño a su bienestar y privacidad, daños a su desempeño laboral y situación laboral, y por prejuicios y estigmas de salud mental en su contra.

Por ejemplo, el 51% de los participantes expresó su preocupación por la privacidad, el 36% señaló el potencial de inferencias incorrectas que los empleadores aceptarían a un valor nominal, y el 33% expresó su preocupación de que las inferencias generadas por la emoción generadas por IA podrían utilizarse para tomar decisiones de empleo injustas.

Voces de participantes

Un participante que tenía múltiples condiciones de salud dijo: La conciencia de que estoy siendo analizado iríacamente tendría un efecto negativo en mi salud mental. Esto significa que a pesar de las emociones que AI afirmó que los objetivos de inferir y mejorar el bienestar de los trabajadores en el lugar de trabajo, su uso puede conducir al efecto contrario: el bienestar disminuido debido a una pérdida de privacidad. De hecho, otro trabajo de mis colegas Roemmich, Florian Schaub y yo sugiere que la pérdida de privacidad inducida por la iniciativa de IA puede abarcar una gama de daños a la privacidad, incluyendo psicológica, autonomía, económica, relación, física y discriminación.

Sobre la preocupación de que la vigilancia emocional pudiera poner en peligro su trabajo, un participante con una condición de salud mental diagnosticada dijo: "Podrían decidir que ya no soy un buen ajuste en el trabajo y despedirme. Decide que no sea lo suficientemente capaz y no te das un aumento, o pensar que no estoy trabajando lo suficiente.

Los participantes en el estudio también mencionaron el potencial de desequilibrios de poder exacerbados y dijeron que tenían miedo de la dinámica que tendrían con los empleadores si la emoción IA se integrara en su lugar de trabajo, señalando cómo el uso de la emoción AI podría potencialmente intensificar las tensiones ya existentes en la relación empleador-trabajador. Por ejemplo, un encuestado dijo: "La cantidad de control que los empleadores ya tienen sobre los empleados sugiere que habría pocos controles sobre cómo se usaría esta información. Cualquier "consentimiento" [por] los empleados es en gran medida ilusorio en este contexto.Emoción AI es sólo una forma de que las empresas monitoreen a los empleados.

Por último, los participantes señalaron posibles daños, como las imprecisiones técnicas de la IA de emoción que potencialmente crean falsas impresiones sobre los trabajadores, y la emoción que la IA crea y perpetúan sesgos y estigmas contra los trabajadores. Al describir estas preocupaciones, los participantes destacaron su temor a los empleadores que confiaban en sistemas de IA de emociones inexactas y sesgadas, particularmente contra personas de color, mujeres y personas trans.

Por ejemplo, un participante dijo: "Quién está decidiendo qué expresiones parece violento, y cómo se puede determinar a las personas como una amenaza sólo por la mirada en su cara? Un sistema puede leer caras, claro, pero no mentes. No puedo ver cómo esto podría ser realmente cualquier cosa menos destructivo para las minorías en el lugar de trabajo.

Los participantes señalaron que se negarían a trabajar en un lugar que utiliza la emoción AI, una opción no disponible para muchos o se involucrarían en comportamientos para hacer que la IA emocional los leyó favorablemente para proteger su privacidad. Un participante dijo: "Ejercería una enorme cantidad de energía enmascarando incluso cuando estaba sola en mi oficina, lo que me haría muy distraído e improductivo, señalando cómo la emoción que el uso de IA impondría trabajo emocional adicional a los trabajadores.

Vale el daño?

Estos hallazgos indican que la IA emoción exacerba los desafíos existentes experimentados por los trabajadores en el lugar de trabajo, a pesar de que los defensores afirman que la emoción AI ayuda a resolver estos problemas.

Si la emoción AI funciona como se afirma y mide lo que dice medir, e incluso si se abordan cuestiones con sesgos en el futuro, todavía hay daños experimentados por los trabajadores, como el trabajo emocional adicional y la pérdida de privacidad.

Si estas tecnologías no miden lo que afirman o son sesgadas, entonces la gente está a merced de algoritmos considerados válidos y confiables cuando no lo son. Los trabajadores todavía tendrían que gastar el esfuerzo para tratar de reducir las posibilidades de ser mal leídos por el algoritmo, o dedicarse a pantallas emocionales que lea favorablemente al algoritmo.

De cualquier manera, estos sistemas funcionan como tecnologías panópticos -como como las tecnologías, creando daños a la privacidad y sentimientos de ser observados.

De nuestro suscriptor: Nazanin Andalibi de La Conversación

¿Cuál es tu reacción?